开发者最为关心的价值点,是当AI辅助从概念迈向实战情况时,是否能够顺利真正落地到后端设计当中,进而解决那些会让人产生“写了就满心厌烦、不改就进展缓慢”之感的棘手难题。然而实际上,这并非只是基于趋势的畅想,而是在2026年年初就能够着手去验证的一整套详尽具体方案。

AI模块与传统后端的协作边界

软件后端引入AI辅助,并非推翻重来,而是于原有分层架构里开辟专门的服务模块。2025年,我们在一家电商公司的订单中心做过测试,接入层经AI分析请求特征后,恶意爬虫拦截率从固定规则下的76%提升到了94%。AI并不取代鉴权逻辑,而是为鉴权提供更精准的输入。

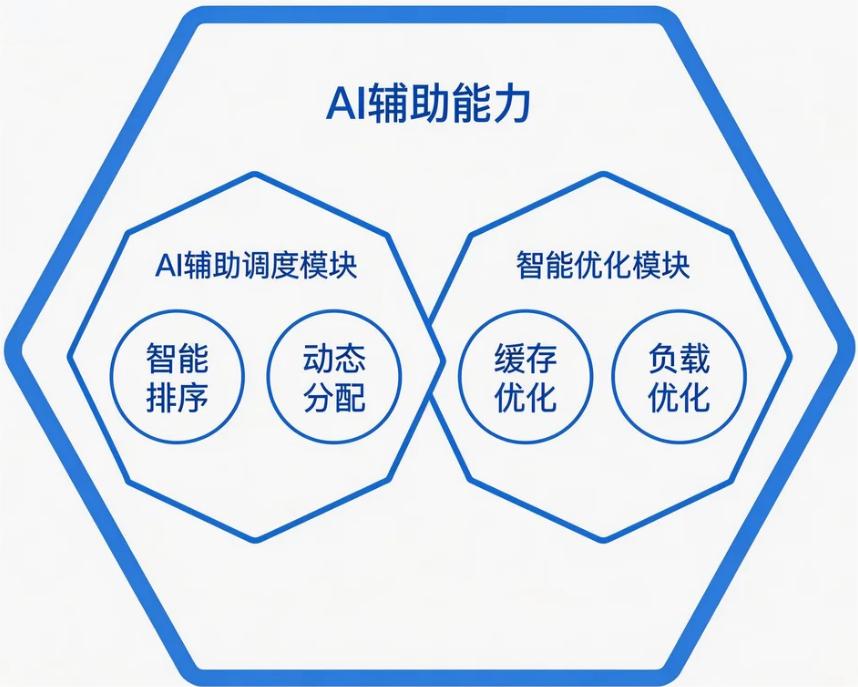

对于业务层而言,让AI去干“协调活”会更具适配性。比如说,存在一个工单系统,它会同时接收来自用户的投诉,还有运维报警以及自动巡检任务,要是靠人工去编写优先级队列,通常会显得僵化。在2026年1月的时候,某SaaS厂商有这样的实践,即AI依据近一周的服务响应SLA、故障影响范围来进行动态排序,最终任务积压时间被缩短至32%。

在数据层里,AI辅助的重点在于缓存以及隐患发现。有一家游戏后端方面的团队,在2025年年底的时候接入了AI去分析PostgreSQL慢查询日志,从而定位出了三个长期以来都没有被留意到的索引失效模式,并且提前一周就规避了春节活动期间可能出现的潜在宕机状况。

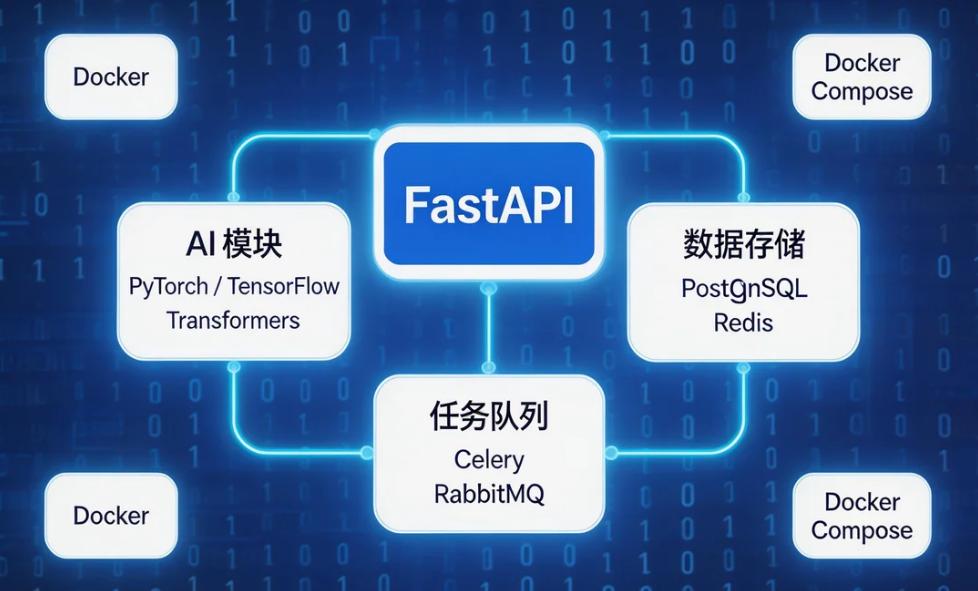

选型锚点:成熟生态与低心智负担

后端基础框架选择FastAPI有着很直接的理由,先从2025年看,就在那次来自JetBrains的调研里,它在国内开发者这个范围中的,有一个满意度,比例达到了89% ,FastAPI的异步性质跟AI模型开展推理那件服务是天然地亲和的。我们团队就在前一年,带着两名实习生去搭建AI做出辅助的原型,凭借FastAPI靠着它这个工具自动生成了OpenAPI文档,然后又有AI模块,它直接读取到接口定义从而生成测试用例,在仅仅一周的里面,就跑通了核心流程。

PyTorch和Transformers库被AI框架锁定,这看中的是HuggingFace的模型复用能力。2026年2月呈现出最新趋势,越来越多后端团队不再对模型进行从头训练,而是去下载将日志异常、流量预测进行微调的轻量级模型,直接于CPU上展开推理,单次请求把耗时控制在50ms以内。

数据层的组合情况保持不变,然而策略发生了变更。有一家从事在线教育的企业,于2025年的第四季度,对Redis缓存更新的逻辑实施了改造,借助AI依据课程的访问热度,来预测未来两小时的热点数据,使得预加载的命中率从61%提升到了83%。PostgreSQL仍然存储着全量数据,AI仅仅读取它的副本用以进行分析。

两个核心模块的功能与构造

AI辅助调度模块落地成为AIAssistService单例,在服务启动之际加载轻量化模型。在2025年年底之时,我们为某物流平台撰写过一个版本,模型依据每个运单的时效要求,当前分拨中心负载,以及异常天气系数,给异步任务打出三个维度的优先级分,替代了原先写死在代码里的四级分类。上线两周后,高优任务的平均等待时长从4.7秒降低到1.8秒。

把系统本身的“自检”作为侧重点的是智能优化模块,在 2026 年 1 月的时候,有一个加入了 AI 辅助接口版本管理的内部工具链项目,该项目拿新接口的调用参数与历史调用模式做模型对比,要是察觉到某字段缺失率突然大幅上升,就会自动回滚到稳定版本还推送告警,就连智能重试机制也是交给 AI 去判断的,要知道并非所有超时情况都值得进行重试,AI 会依据下游服务负载以及错误码分布情况,只有在恢复概率超过70%的时候才进行重试。

从代码到服务的部署协同

某开源后端项目在2025年于GitHub上放出了AI辅助版,该AI辅助版拆了三个服务,分别是主后端、AI推理服务以及模型热更新守护进程,Docker Compose依旧是现阶段当中最为稳妥的编排施行方案,其启动顺序是依照原本固定写好在yml文件里的,开发者只要执行up命令便能够将全部的程序依赖运行通畅。

在迭代之际,模型服务单独部署的优势得以显现。于2026年2月,有一个医疗SaaS团队,其需要对异常检测模型进行更新,在这个过程中,他们仅仅重启了AI服务容器,而主后端处于零中断状态。模型文件被放置于挂载卷当中,当新版本下载完成后会自动进行替换,若要回退,也仅仅只需更改标签并重启即可。

进行测试的入口借助FastAPI的Swagger页面是足够直观的。去年的时候,有一个学生团队开展课设,在写完AI调度接口之后,直接于UI上通过点选的方式来传参,进而看到了任务队列的模拟分配结果,仅仅十分钟就验证了模型是不是生效。这样的低验证门槛对于新手而言非常重要。

适配与扩展的真实姿态

这套结构的起始点是“不改变原本存在的业务代码主要部分”,在 2025 年的第三个季度,我们帮忙去改造一个借助 Django 编写的后台管理的,且业务逻辑全都处于 views.py 之中,重构风险较高的项目,最后仅仅是在启动的阶段额外初始化了一个 AI 服务的实例,在业务代码里那些有着进行决策需求的地方调用它的方法,历经两周达成试点上线。

在横向方向上添加能力这一情况体现出扩展性,在2026年1月的时候,有一个IoT后端,首先在设备数据入库的环节添加了AI异常识别,当运行处于稳定状态之后,又在告警模块添加了根因分析。每一个功能均是独立意义之上的AI辅助模块,和原系统产生的耦合仅仅只剩下一个接口调用以及几个配置项。

针对中小型团队而言,最为看重的一点是,不要被死死束缚住。在技术栈这个范畴当中,FastAPI是能够替换为Spring Boot的,PyTorch也是能够替换为ONNX Runtime的,只要是能够维持服务之间的契约足够清晰,而且迁移成本是在可控范围之内的。

你身处日常开发期间,有无遭遇过那样一些后端场景,这类场景呈现为人去书写会极为繁琐,而借助机器来完成能够实现更高的精准度,并且你会乐意试着交付给AI辅助模块呢,期待你在评论区域分享你精准确切的需求。要是你觉得所涉内容具有实用价值,可行的做法是进行点赞并予以转发,从而使得更多后端开发者得以目睹这套具备实际得以贯彻实施可能性的方案。